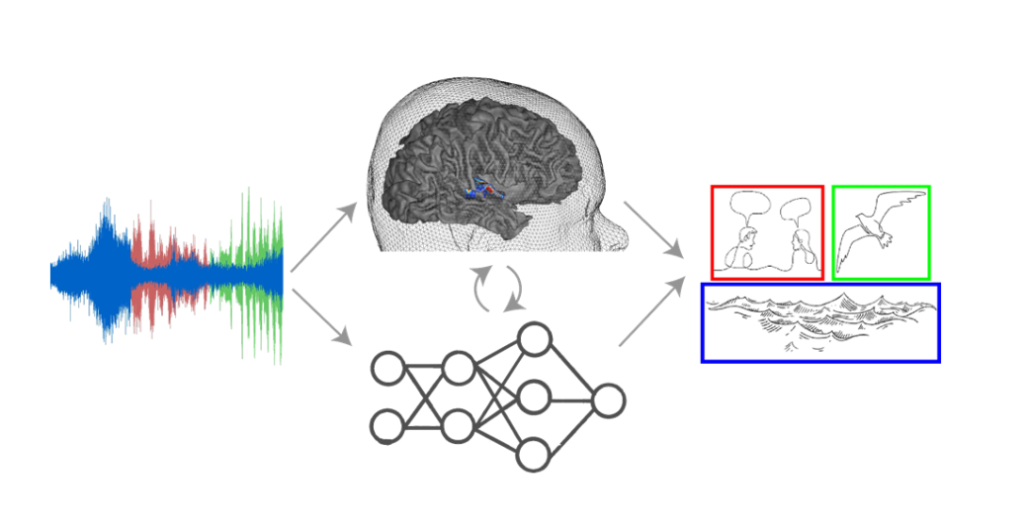

Elia Formisano, professor Neural Signal Analysis, heeft samen met zijn collega Bruno Giordano van het CNRS in Frankrijk de felbegeerde Synergy Grant ontvangen van de European Research Council. Het project is getiteld Natural Auditory SCEnes in Humans and Machines (NASCE): Establishing the Neural Computations of Everyday Hearing en ze zullen onderzoeken hoe onze hersenen geluidslandschappen verwerken, hoe de verschillende geluiden worden gescheiden en gekoppeld aan objecten en gebeurtenissen. Ze zullen gedrags- en hersenreacties bij menselijke luisteraars onderzoeken en AI-modellen creëren die de waargenomen mechanismen kunnen repliceren.

“In het echte leven hoor je bijna nooit maar één geluid. Dus met dit project ontwikkelen we deze theorie en dit model verder om te kijken hoe de hersenen zo goed zijn in het van elkaar scheiden van verschillende geluiden en ze te koppelen aan de juiste objecten”. Deze kwaliteit is een van de eerste dingen die we als mensen verliezen als we ouder worden, het scheiden van geluiden wordt steeds moeilijker. “We stellen een nieuwe theorie voor over hoe de hersenen dit doen, genaamd: Semantic Segmentation”. Met deze subsidie kunnen ze de theorie ontwikkelen en bewijzen.

“We combineren actief drie belangrijke disciplines: Cognitieve psychologie, neurowetenschappen en kunstmatige intelligentie. We kijken naar menselijk gedrag, het brein en AI-modellen. In onze experimenten zullen we zien hoe de werkelijke meting van gedrag en het brein zich verhouden tot de neurale netwerken”.

Lees het hele verhaal op de site van Maastricht University.