Mijn dank aan Jos Baijens voor de uitnodiging om bij te dragen aan het Beste ID forum. In dit stuk geef ik antwoorden op vragen die hij mij stelde over AI, cognitie, complexiteit, en de bredere wetenschappelijke en maatschappelijke context van mijn onderzoek.

Wanneer we denken dat AI systemen iets dieps reflecteren over onszelf en ons denken, dan creëren we verwrongen en verarmde denkbeelden over onszelf en ons denken. – van Rooij, Guest, et al. (2024)

Wat is AI, en wat niet?

‘Artificiele intelligentie’, afgekort ‘AI’, heeft veel verschillende betekenissen.[1]

Soms verwijst ‘AI’ naar het idee dat we intelligentie in kunstmatige systemen kunnen nabootsen, danwel naar een specifiek systeem dat artificiele intelligentie zou bezitten. Men maakt onderscheid tussen domein-specifieke AI systemen (bijvoorbeeld een schaakcomputer) en AI-systemen die net als mensen algemene intelligentie bezitten (artificial general intelligence of ‘AGI’ genaamd). Of AGI echt kan bestaan is omstreden.

Er zijn nog veel meer betekenissen.

De term ‘AI’ verwijst soms ook naar het idee dat we menselijke cognitie met computermodellen kunnen verklaren (AI als cognitiewetenschap), of naar een ideologie dat mensen door machines vervangen kunnen worden (AI als ideologie), of de term wordt gebruikt om mensen te laten geloven dat technologische systemen slimmer zijn dan ze werkelijk zijn (AI als marketing). Tevens kan ‘AI’ verwijzen naar één of meer onderzoeksvelden, bijvoorbeeld machine learning, robotica, taal-technologie, en de eerdere genoemde cognitiewetenschap.

AI is dus niet maar één ding.

Ook is AI niet nieuw. Als idee, systeem, en onderzoeksveld bestaat het al lang.[2]

Desondanks denken veel mensen dat AI iets nieuws is en bijvoorbeeld een paar jaar geleden met ChatGPT op het podium is verschenen. Dit is een misvatting. Ook is het onverstandig om de term ‘AI’ te gebruiken voor systemen als ChatGPT. Dat zet mensen op het verkeerde been. Een betere term in zo’n geval is Mechanical Turk[3] of automated plagiarism[4]: Geen echt AI-systeem, maar wel de schijn ervan.

Wat is cognitie? Wat is cognitiewetenschap?

Cognitie[5] is een verzamelnaam voor allerlei mentale vermogens, zoals denken, redeneren, waarnemen, probleem oplossen, plannen, beslissen, oordelen, geheugen, aandacht, enzovoorts. Het omvat alles wat we ook onder alledaagse termen als ‘intelligentie’, ‘brein’, of ‘psyche’ verstaan.

De wetenschappelijke studie van cognitie heet cognitiewetenschap. Deze wetenschap bestudeert vragen zoals: Hoe werkt denken, waarnemen, redeneren, leren, enzovoorts? Zijn brein (hersenen) en cognitie (denken, etc.) hetzelfde ‘ding’, of zijn dat twee verschillende dingen. Hoe is het mogelijk dat we de wereld in 3D waarnemen terwijl de retina 2D is? Hoe kan een baby makkelijk elke mogelijke mensentaal leren? En waarom is dat moeilijker als volwassene? Zitten er plaatjes of symbolen in ons brein wanneer we ons mentaal iets voorstellen? Hoe kunnen we communiceren, tussen de regels lezen, en grappen begrijpen? Is ons brein een soort computer?

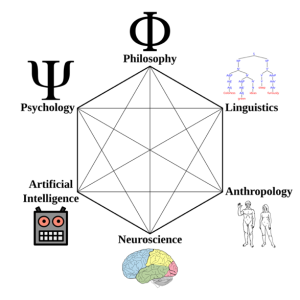

De cognitiewetenschap is een multidisciplinair onderzoeksveld, oorspronkelijk gevormd door zes disciplines, Psychologie, Filosofie, Linguïstiek, Antropologie, Neurowetenschappen, én Artificial Intelligentie (AI).

Afbeelding 1. https://en.wikipedia.org/wiki/Cognitive_science

Wat hebben AI en cognitie met elkaar te maken?

Als onderzoeksveld is AI één van de zes cognitiewetenschap-disciplines (zie Afbeelding 1). Zoals eerder vermeld, baseert AI zich op het idee dat we cognitie met computermodellen kunnen verklaren en/of nabootsen.

Mensen onderschatten vaak wat de menselijke cognitie allemaal kan, en overschatten wat AI systemen kunnen. Velen geloven dat hedendaagse AI systemen zich binnenkort tot echte AGI zullen ontpoppen (of zelfs al AGI zijn). Mijn collega’s en ik hebben onlangs wiskundig bewezen dat dit onzin is.[6]

Wat zijn de grenzen van AI?

Computers kunnen heel veel berekenen (ook wel, ‘computatie’ genoemd). Maar er zijn grenzen. Theoretische informatici, logici, en wiskundigen bestuderen deze grenzen.

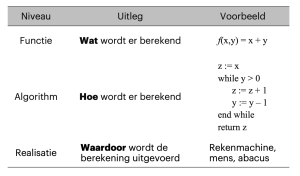

Om uit te leggen hoe dit in z’n werk gaat is het handig een onderscheid te maken tussen drie niveaus waarop we een berekening kunnen beschrijven: functie, algoritme, en realisatie (zie Tabel 1 voor een uitleg en voorbeelden).

Tabel 1. Functie, algoritme, en realisatie

Er bestaan functies waarvoor geen enkel algoritme bestaat. Dergelijke functies zijn onberekenbaar (Engels: uncomputable). Er zijn ook functies die wel in theorie maar niet in de praktijk berekenbaar zijn, omdat elk algoritme voor zo’n functie astronomisch veel stappen moeten nemen om de berekening te voltooien ongeacht waardoor de berekening wordt uitgevoerd (mens, machine, of wat dan ook). Zulke functies noemen we onhandelbaar (Engels: intractable).

AI systemen kunnen alleen die functies berekenen die praktisch berekenbaar zijn.

Wat is NP-compleetheid?

NP-compleetheid is een wiskundig concept dat o.a. gebruikt kan worden om te bepalen welke functies praktisch berekenbaar zijn en welke onrealistisch veel tijd kosten. Bijvoorbeeld, een berekening die miljoenen jaren kost is niet realistisch als we de uitkomst volgende week nodig hebben.

NP staat voor Non-deterministische Polynomiale tijd. Dat is een hele mond vol. Simpelgezegd is NP de klasse van functies F waarvoor het volgende geldt:

Stel we zouden de juiste uitkomst van de berekening van F op magische wijze kunnen raden (= non-deterministisch), dan zouden we de correctheid van die uitkomst snel (in polynomiale tijd)[7] kunnen checken.

NP staat dus voor ‘snel te checken’.

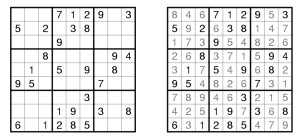

Er zijn echter functies in NP waarvoor niemand ooit een ‘snel te berekenen’ algoritme heeft kunnen vinden: de zogeheten NP-complete functies. Neem bijvoorbeeld Sudoku. Een oplossing van een Sudoku puzzel is makkelijk te checken, maar niet altijd makkelijk te vinden.

Sudoku

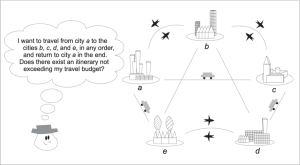

Nog een voorbeeld is het Handelsreizigersprobleem: Een handersreiziger wil een aantal steden bezoeken maar heeft maar een beperkt reisbudget. Er bestaat geen methode die gegarandeerd werkt zonder alle mogelijke routes te checken. Voor 5 steden moet een handelsreiziger 12 mogelijke routes checken. Dat is nog wel te doen. Maar voor bijvoorbeeld 20 steden is het aantal routes al meer dan 10,000,000,000,000,000 (lees: 10 miljoen biljoen), en voor 30 steden is het aantal routes meer dan het aantal seconden sinds de Big Bang. Dat is dus onmogelijk om binnen een mensenleven allemaal te checken. We zeggen dan: het probleem is onhandelbaar (Engels: intractable).

Het handelsreizigersprobleem. Beeld: Iris van Rooij.

Inmiddels zijn er honderden NP-complete functies bekend en is er een 1,000,000 dollar prijs uitgeloofd voor wie een efficient algoritme kan vinden, dan wel kan bewijzen dat er geen efficiënt algoritme bestaat. De meeste informatici, logici, wiskundigen denken dat het laatste het geval is.[8]

Waar gaat jouw onderzoek over?

Ik bestudeer o.a. de reikwijdte en grenzen van cognitie, cognitiewetenschap, en AI. Ik maak hiervoor gebruik van wiskundige concepten zoals NP-compleetheid en verwante concepten uit de parametrische complexiteitstheorie.[9] Ik schreef o.a. een tekstboek over deze benadering, zodat andere cognitiewetenschappers de concepten en methoden kunnen gebruiken voor hun eigen onderzoeksvragen.

Boek Van Rooij e.a.

En het onderzoek van jouw collega’s in Nederland?

Mijn collega’s in de Computationale Cognitive Science onderzoeksgroep aan de Radboud Universiteit in Nijmegen hebben ieder hun eigen specialisme en tezamen dekken we grote delen van de zes disciplines. Een gedeelde missie is om bij te dragen aan theoretische vooruitgang in de cognitiewetenschap. Ook zetten we fundamentele kennis in voor kritische reflectie op de rol van AI in wetenschap en maatschappij. Deze benadering is uniek, niet alleen in Nederland maar ook internationaal.

Wat wordt er in de EU en wereldwijd onderzocht?

Veel andere onderzoekers in Europa en wereldwijd reflecteren ook kritisch op AI. Hun onderzoek laat o.a. zien hoe AI-technologieen (systemen) een grote ecologische footprint hebben, discriminatie vaak automatiseren en verhullen, gebouwd zijn met gestolen data en exploitatie van onbetaalde werk. Ik heb een blogpost samengesteld met dat soort “kritische lensen op AI”.

Wat is jouw kritiek op het AI-discourse?

Het discourse wordt op dit moment gedomineerd door een AI hype. Mijns inziens gaan te weinig wetenschappers hier tegenin. Vaak komen ze met dooddoeners als “AI is er nu eenmaal, dus we kunnen het maar beter omarmen”. Ik vraag me soms af waar die slogan vandaan komt, en wie daar geld aan verdient. Er zijn ook veel wetenschappelijke collega’s in Nederland die mijns inziens bijdragen aan en/of meeliften op deze AI hype cyclus. Ik vind dat zelf onverantwoordelijk. Ik schreef hier ook over op mijn eigen blog: “Stop feeding the hype and start resisting”.

Wat zijn voor jou belangrijke open vragen? Waar twijfel je over?

Een belangrijke open vraag voor mij is of we cognitie wel echt computationeel kunnen begrijpen en verklaren. Ons recent onderzoek, waar ik al eerder naar verwees, laat zien dat we dat in ieder geval niet kunnen door cognitie na te bootsen in programma’s en machines. Maar het blijft een open vraag is of het op een andere manier wel kan, bijvoorbeeld door wel conceptueel gebruik te maken van concepten uit de computerwetenschap, maar zonder iets te “bouwen”.

Waar ik over twijfel? Hoe de grenzen van onze cognitie ons begrip van cognitie begrenst.

Wat zijn je toekomstverwachtingen?

Mijn toekomstverwachtingen zijn dat AI-systemen meer en meer publieke domeinen gaan infiltreren en corrumperen. Je ziet de macht van Big Tech alleen maar toenemen, ook met de laatste VS-verkiezingen.[10] Maar ook in Nederland zie ik dat Big Tech overal achteloos en kritiekloos wordt binnengelaten als een Paard van Troje: in onderwijsinstellingen, justitie, gezondheidszorg, wetenschap, journalistiek, enzovoorts.

Ondertussen wordt mensen wijsgemaakt dat de gehypete AI systemen écht intelligent zijn, en belangrijke cognitieve taken van docenten, rechters, dokters, wetenschappers, journalisten en andere professionals kunnen overnemen. Ik verwacht dat het belang van AI als cognitiewetenschap alleen maar groter wordt, om tegenwicht te kunnen bieden aan dit soort misinformatie. Ik heb vertrouwen dat de jongere generatie door deze onzin kan gaan prikken. Maar daartoe moeten we wel inzetten op het onderwijzen van meer kritische AI-Geletterdheid.

[1] Zie ook Tabel 1 in van Rooij, Guest, et al. (2024).

[2] Hoewel de term ‘AI’ uit de vijftiger jaren van de vorige eeuw stamt, is het idee dat menselijke denken en handelen mechanistisch verklaard of nagebootsts kan worden honderden tot duizenden jaren ouder.

[3] https://en.wikipedia.org/wiki/Mechanical_Turk

[4] https://irisvanrooijcogsci.com/2022/12/29/against-automated-plagiarism/

[5] https://en.wikipedia.org/wiki/Cognition

[6] https://www.ru.nl/onderzoek/onderzoeksnieuws/trap-er-niet-in-ai-zo-slim-als-mensen-is-verre-van-onvermijdelijk

[7] D.w.z. het aantal rekenstappen groeit langzamer dan een polynomiale functie (bijv. n, n2, n3, etc.) van de inputgrootte n (bijv. voor de function f(x,y) = x + y, de grootte van de input is n = |x| + |y|).

[8] Deze korte video legt dit helder uit: https://www.youtube.com/watch?v=YX40hbAHx3s

[9] van Rooij, I., Blokpoel, M., Kwisthout, J., & Wareham, T. (2019). Cognition and intractability: A guide to classical and parameterized complexity analysis. Cambridge University Press.